关注公众号【算法码上来】,每日算法干货马上就来!

今天是12.13,一晃二十六周岁了。从2017年开始,每年都会简单总结一下一年中经历的事情,不知不觉已经五年了。

二零一七年终总结

二零一八年终总结

二零一九年终总结

二零二零年终总结

回顾过去五年,从大三到今年毕业正式工作,好像干了很多事情,又好像什么都没干。也就混到硕士毕业,侥幸发了篇ACL,然后又侥幸进入字节从事新的研究方向。这五年来唯一不变的可能就是一直在打英雄联盟吧,还是当年的开黑队友,还是熟悉的味道。

2021年是正式成为社会人的一年,从校园老油条蜕变为了职场萌新。总结下来就是,上半年在忙着毕业,下半年在忙着开发LightSeq。

今年过年在上海度过了人生第一个不在家的春节,一是因为疫情回去要做核酸,二是因为毕业论文没多久要交了。连编带凑,花了将近一个月赶出了一篇像模像样的毕业论文。后面的毕业流程走的出乎意料的快,导师也没怎么修改,短短数周就答辩结束,仿佛学校盼着我们早日离校步入社会。拿完优秀毕业生、优秀毕业论文和国家奖学金,实验室最后聚了聚餐,接着就正式毕业了。

学校里的事就这么多了,主要精力还是在公司里。上半年进一步完善LightSeq推理引擎,写了很多文章对LightSeq进行了大量的介绍和宣传,也给很多想入门CUDA和模型加速的同学科普了基本的知识。

还在NAACL 2021上发表了一篇关于LightSeq推理引擎相关技术的论文,进行了技术沉淀,推理引擎的开发也算是告一段落了。

论文地址:LightSeq: A High Performance Inference Library for Transformers

今年最重要的工作内容要数LightSeq训练引擎了,从4月份开始,到6月份结束,历时三个月和同事们一起开发出了业界首个Transformer全流程训练加速引擎。训练引擎从0到1的整个过程我都有参与,这期间为了快速融入到项目的开发中,不得不自学了CUDA和模型加速的相关知识,这些之前在学校都是没有接触过的。项目开源后也投递了论文,虽然没有中,但也积累了不少经验,懂了一些系统领域会议论文的写法。leader还安排我去QCon大会进行了分享,宣传了一波LightSeq技术。

论文地址:LightSeq2: Accelerated Training for Transformer-based Models on GPUs

目前的话在开发LightSeq量化推理,在不久的将来就会和大家正式见面,模型推理速度也将迈上一个新的台阶。

生活方面,下半年重新开始做饭了,外卖一方面不卫生,一方面也吃腻了,不一定有自己做的好吃。不过租的房子厨房实在太小了,做一次饭都要收拾很久,经常也会不想做。限于篇幅,这里就只放几张图吧,更多的可以去我朋友圈围观。

虽然房子小,10月底家里还是新增了一员,我从师兄家抱回了一只布偶猫。养猫给我的生活新增了不少乐趣,没事的时候可以撸一撸。但也带来了很多麻烦,猫经常乱拉,晚上睡觉吵人,每天要铲屎喂粮,就和带一个孩子一样。可能是我给他吃的太好了吧,才6个月左右就已经长到10斤了。

情感方面依旧维持原样,虽然有过小插曲,但都不合适。

今年给我最大的感觉就是,工作了之后时间变快了,生活变单调了。尤其是取消大小周之后,每周都过得好快,每次还没恍过神就又到下一个周末了。这可能也和我比较宅有关,每周末除了打游戏,就还是打游戏。睡眠时间也依旧很晚,不断摧残自己的身体。

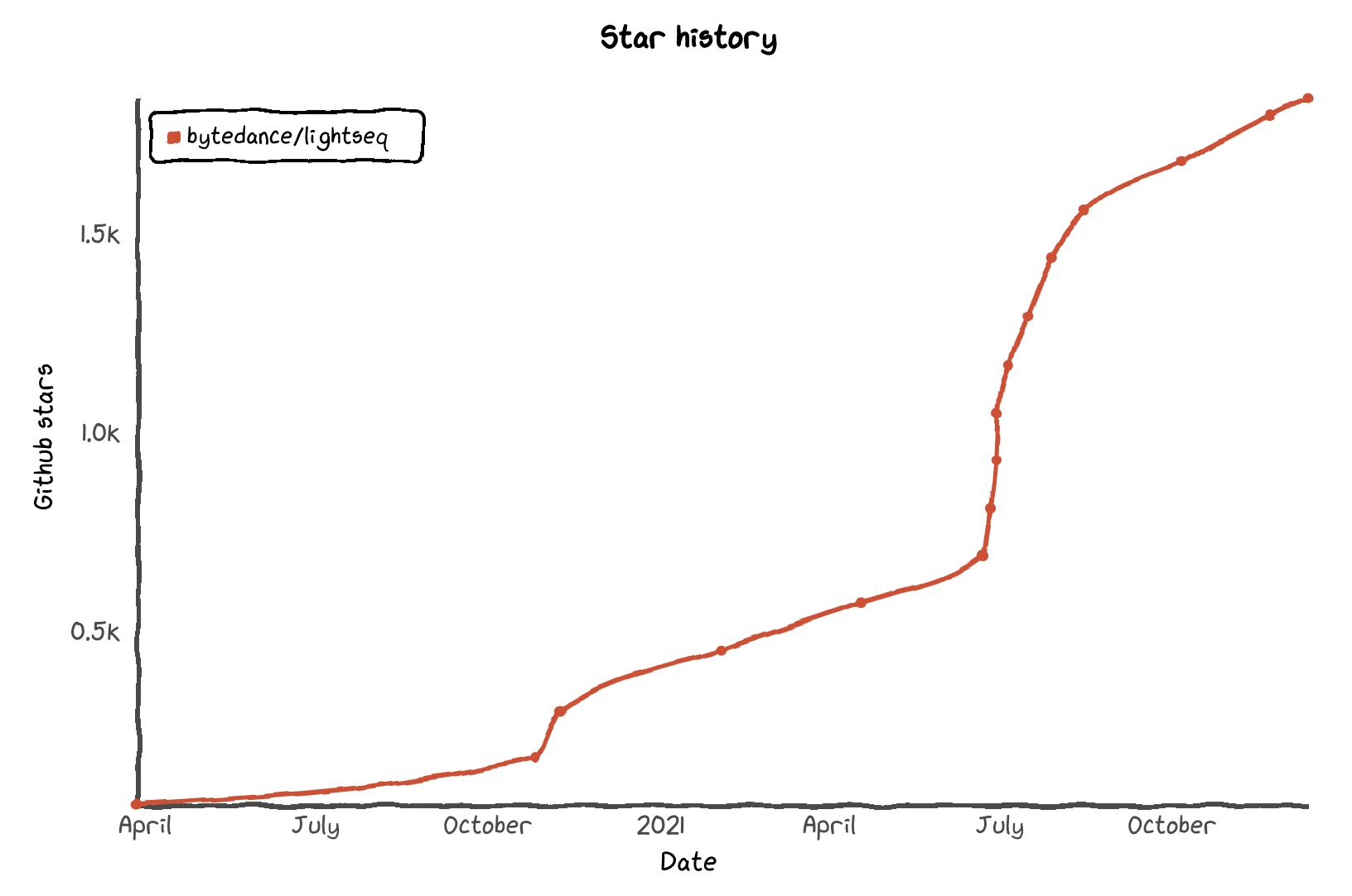

对于2022年,最大的心愿还是把工作做好,先把模型量化做完善了,争取早日晋升,希望LightSeq的star早日能上3000。然后继续做好菜、养好猫,快乐游戏每一天。文章最近更新的也没有以前频繁了,得勤快一点了。